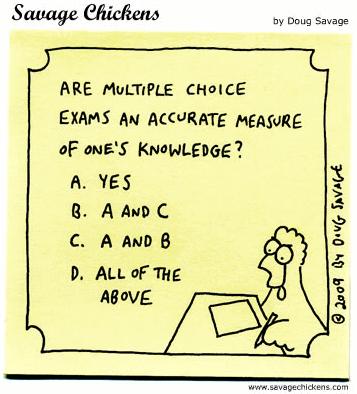

Le “cycle de formations en pédagogie médicale”, organisé par l’équipe de l’éducation médicale de l’Université du Luxembourg, a pour but de promouvoir l’échange entre enseignants, de partager des idées innovatrices et de lancer la discussion sur des sujets importants, tout cela dans un cadre convivial. La présentation et l’utilisation de nouvelles technologies sont également au rendez-vous.

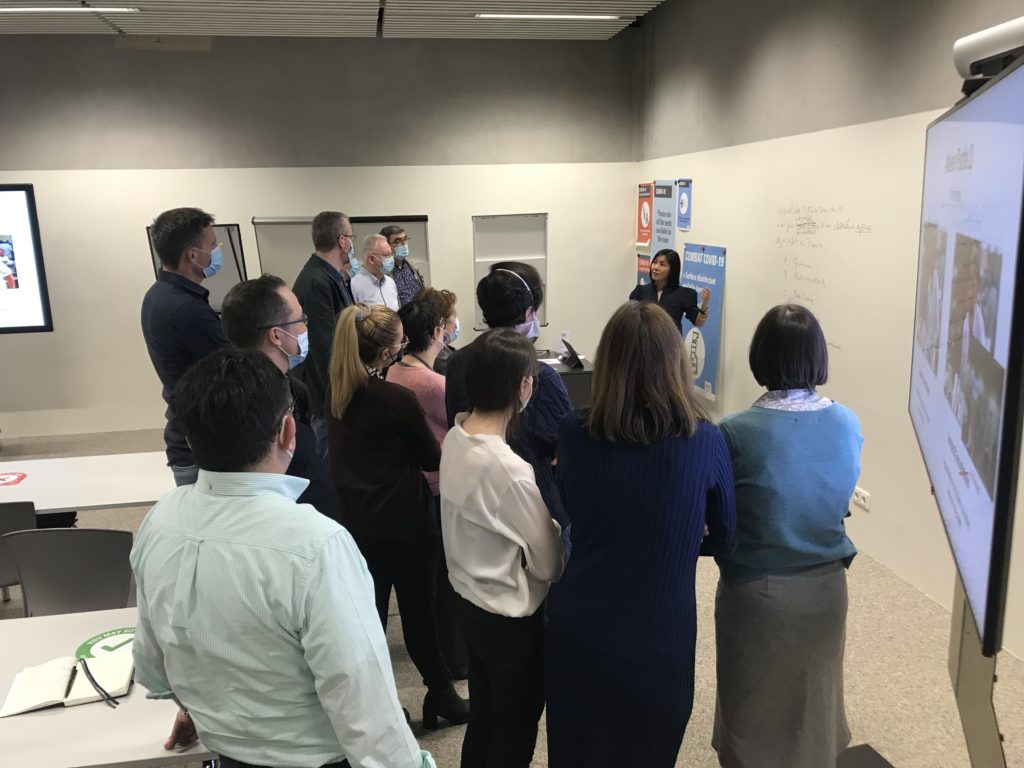

La deuxième édition, célébrée en date du 10 mars 2022 à la Maison du Savoir, a abordé le sujet “La docimologie – Evaluation de l’apprentissage et évaluation de l’évaluation”. La séance fut dirigée par Dr Thanh-Van Trieu, pédiatre à la KannerKlinik du CHL et experte en pédagogie médicale, et Dr Christian Grévisse, PhD en informatique et e-learning specialist à l’Université du Luxembourg. 28 participants, pour la plupart des médecins enseignant au sein du Bachelor en Médecine et des Diplômes d’Etudes Spécialisées, participaient à la séance qui était suivie d’un cocktail dînatoire.

Introduction

Le mot “docimologie” vient du grec 🇬🇷 “dokimé” (l’épreuve) et “logos” (l’étude, la science). Le dictionnaire la définit comme “l’étude systématique des facteurs déterminant la notation des examens et des concours”. Plutôt qu’un simple synonyme d'”évaluation”, la docimologie peut être considérée comme la science des examens, permettant de mesurer la qualité des épreuves (Bertrand et al., 2016). D’ailleurs la création d’épreuves de haute qualité n’est pas simple. Dès lors, la séance se centrait sur ces deux aspects:

- l’évaluation de l’apprentissage, via des épreuves

- l’évaluation de l’évaluation, donc l’analyse docimologique

Au sujet des évaluations

Des évaluations se présentent à différents moments lors du processus d’apprentissage, selon leur but (Bertrand et al., 2016). On distingue notamment entre:

- L’évaluation diagnostique: Elle mesure le niveau de connaissances des apprenants et permet d’identifier des méconnaissances. Elle est généralement organisée au début d’un cours.

- L’évaluation de sélection: Une sous-catégorie de l’évaluation diagnostique, celle-ci permet d’identifier les meilleurs candidats, pour un emploi ou un cycle d’études avancées.

- L’évaluation formative: Souvent animée en forme de quiz interactif, elle accompagne l’apprenant et indique son progrès, tant à lui-même comme à l’enseignant, ce qui pourrait permettre un ajustement de l’approche pédagogique. L’évaluation formative peut se faire à différents moments aussi, comme déjà mentionné lors de la première édition du cycle de formations. Afin qu’une évaluation soit vraiment formative et non seulement indicative, il faut donner à l’apprenant un retour (Shank, 2021) sur sa performance, soit automatisé (p.ex. des explications pourquoi un choix était correct ou non), soit manuel (p.ex. écrire un commentaire sur un devoir corrigé).

- L’évaluation sommative: Elle vérifie si les objectifs d’apprentissage ont été atteints, généralement en donnant une note à l’apprenant.

- L’évaluation certificative: Cette dernière, en cas de succès, mène à la délivrance d’une attestation, d’un diplôme, voire d’une autorisation d’exercice.

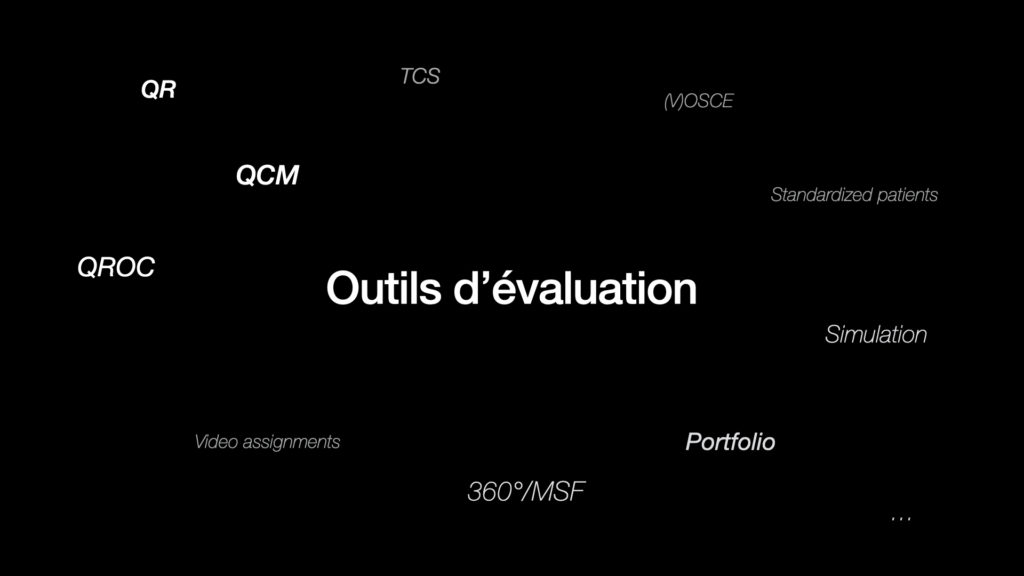

Evidemment, il existe une panoplie d’outils d’évaluation, comme l’indique l’image suivante:

- Les questions à choix multiple (QCM), les questions à réponse ouverte courte (QROC) et les questions rédactionnelles (QR) sont des moyens traditionnels et vastement répandus, non seulement en pédagogie médicale.

- Les tests de concordance de script (TCS) sont un outil de résolution de problèmes complexes pour entraîner le raisonnement clinique, le jugement professionel ainsi que la perception dans des contextes d’incertitude.

- L’examen clinique objectif structuré (ECOS, ou OSCE en anglais) réunit différentes stations pour déterminer à la fois les connaissances, la performance pratique et les compétences comportementales. Une des stations peut notamment être un patient-standardisé, acteur qui simule une pathologie, ou d’autres formes de simulation (p.ex. des simulateurs procéduraux [task trainers], des mannequins haute fidélité, …)

- Le portfolio sert à documenter l’apprentissage et formuler des réflexions. Cet outil est beaucoup utilisé dans l’étude de la médecine ainsi que les sciences de l’éducation, mais elle peut également suivre un but de formation continue.

- La méthode 360° (également appelée “multi-source feedback”, MSF) permet d’analyser le comportement professionnel à travers le témoignage de différents acteurs autour d’un candidat (p.ex. le maître de stage, les infirmiers, les patients, d’autres médecins, le personnel administratif, …).

- Les “video assignments” (Jones & Wisniewski, 2021): Nouveaux au monde de l’évaluation formative, les plateformes comme Flipgrid permettent de collecter des réponses-vidéo de la part des étudiants sur un sujet donné.

Attention à l’alignement pédagogique!

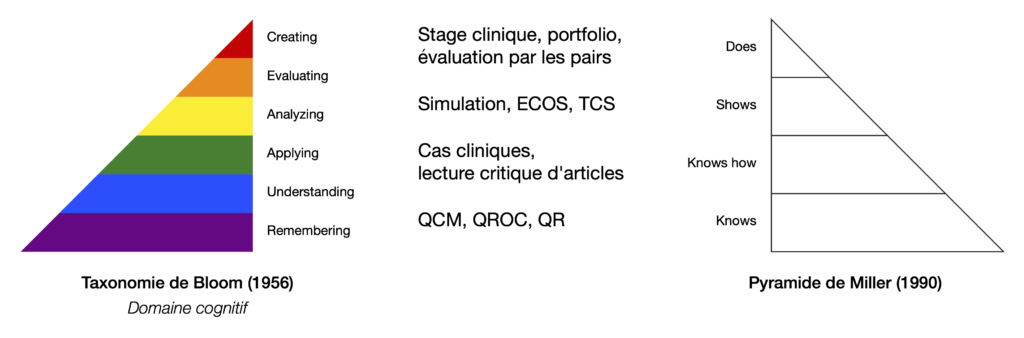

Les modèles pédagogiques comme la taxonomie de Bloom (Bloom, 1956) ou la pyramide de Miller (Miller, 1990), définissent des niveaux de compétences qu’un apprenant parcourt le long de ses études. L’évaluation de ces compétences doit être soigneusement choisie. Si une cohérence existe entre les compétences attendues, l’enseignement donné et l’évaluation réalisée, on parle d’alignement pédagogique (Bertrand et al., 2016). C’est ainsi qu’un outil d’évaluation peut être approprié pour un certain niveau de compétences, mais déconseillé pour un autre. Par exemple, les QCM ne sont guère propices pour évaluer un geste, similaire à la simulation pour apprécier les connaissances déclaratives (le “quoi ?”, les faits et règles).

Faire le bon choix d’un outil d’évaluation n’est pas trivial, mais il existe certains critères qui peuvent aider (Bertrand et al., 2016):

- La validité: Elle répond à la question “Est-ce que l’outil mesure ce qu’il a pour objet de mesurer ?” On distingue surtout entre validité de construit (déterminant si l’outil est à même d’évaluer une compétence) et validité de contenu (déterminant si les concepts couverts sont représentatifs et équilibrés quant à l’enseignement).

- La fidélité (“reliability”): Elle détermine si, pour des conditions similaires, l’outil aurait donné un score similaire à un candidat. En effet, la note sur une question rédactionnelle peut diverger, selon le correcteur.

- Autres critères: objectivité, faisabilité, acceptabilité, effets sur l’apprentissage

La séance se concentrait sur les niveaux inférieurs de ces deux modèles pédagogiques et leur évaluation par les QCM. Les mesures relatives aux critères de validité et de fidélité seront présentées à la fin.

L’art des questions à choix multiples

Les QCM peuvent être utilisées dans des évaluations diagnostiques, formatives ou sommatives, ciblées sur les connaissances déclaratives. Elles peuvent couvrir une grande quantité de connaissances et peuvent être automatiquement corrigées par des outils techniques (voir en bas). Une QCM suit normalement la structure suivante (Bertrand et al., 2016; Shank, 2021):

- un texte d’amorce ou énoncé (anglais: “stem”) court, mais qui inclut la majorité de l’information, au mieux formulé d’une façon positive. Il peut être sous la forme d’une question ou d’une phrase à compléter.

- des propositions, dont

- 1 ou plusieurs clés (“keys”): la réponse correcte (ou la meilleure, en cas de jugement d’une situation proche de la réalité). En cas de plusieurs clés, il est recommandé d’indiquer leur nombre à la fin de l’énoncé.

- des distracteurs plausibles

Il existe un débat sur le nombre de propositions à mettre dans une QCM, en règle générale se situant entre 3 et 5. Le fait qu’une QCM ne contienne que 3 propositions ne la rend pas nécessairement moins qualitative qu’une QCM à 5 propositions. S’il est vrai qu’un nombre plus élevé de propositions diminue la probabilité de trouver la bonne réponse en devinant, il est aussi difficile d’inventer des distracteurs qui restent plausibles (Shank, 2021). Le “guide des outils d’évaluation CanMEDS” le confirme:

“Les QCM demeurent fiables et valides avec seulement trois options, probablement parce que deux distracteurs très plausibles sont utilisés plutôt qu’un grand nombre de choix non plausibles.”

(Lee, 2006)

Des éléments multimédia (images, son, vidéos) peuvent faire partie d’une QCM, s’ils sont pertinents pour la résolution de la question, des éléments purement décoratifs pouvant augmenter la charge cognitive (Shank, 2021). Ainsi, un cardiologue pourrait donner comme propositions non pas du texte, mais des tracés d’électrocardiogramme.

Ateliers

Deux ateliers étaient proposés aux participants:

Atelier 1

Les participants pouvaient apprécier des QCM réelles, posées lors des examens du 3e semestre de notre Bachelor en Médecine. Chaque question était accompagnée d’un code QR, renseignant sur la matière, l’indice de difficulté et l’indice de discrimination (voir en bas). Les questions étaient choisies ou bien dû à un certain défaut ou à cause d’un élément positif. Les participants pouvaient écrire leurs commentaires en bas de la question. Cet atelier permettaient d’avoir un consensus sur les bonnes et mauvaises pratiques.

Atelier 2

Les participants étaient demandés à élaborer des QCM sur le sujet de la douleur chez l’enfant. Cet atelier les confrontait directement avec les difficultés liées à l’élaboration de QCM de haute qualité.

Bonnes pratiques pour les QCM

Tant les résultats de l’atelier 1 comme la littérature (Bertrand et al., 2016; Shank, 2021; Vachon Lachiver et al., 2017) recommendent les pratiques suivantes pour créer des bonnes QCM:

- L’étudiant qui connait la bonne réponse ne devrait pas être empêché de la choisir en raison d’éléments langagiers ou logiques. De cette façon, tant l’utilisation excessive d’éponymes (p.ex. “canal de Sténon” au lieu de “conduit parotidien”), ou de questions à patron de réponse (les propositions étant des combinaisons logiques d’un autre ensemble de propositions) sont à proscrire.

- L’étudiant qui ne connaît pas la bonne réponse ne devrait pas pouvoir se baser sur des indices lui permettant de deviner la réponse correcte. Ainsi, un énoncé sous forme de phrase à compléter et qui se termine par l’article féminin “la …” mènerait fort probablement aux étudiants d’exclure des propositions commençant par un nom masculin. De la même façon, les propositions devraient être d’une longueur comparable, les clés ne devant pas être plus détaillées que les distracteurs.

- Les distracteurs doivent être plausibles. On peut les créer à partir d’idées fausses ou en paraphrasant la clé.

- Eviter la proposition “toutes les réponses”, car elle peut être légèrement écartée si un autre distracteur est rejeté.

- Eviter la proposition “aucune de ces réponses”, car elle ne montre pas vraiment ce que les apprenants savent.

- Il est recommandé de rédiger les questions en préparant ou juste après avoir donné le cours pour tenir compte de la manière de l’enseignement (Nilson, 2016).

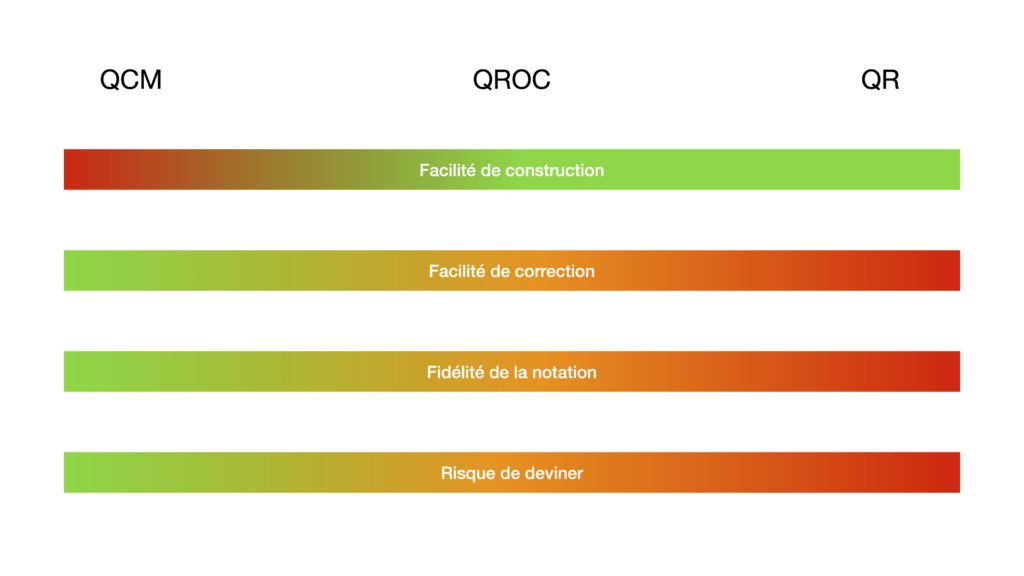

QCM vs. QROC et QR

Il y a des avantages et désavantages pour ces 3 types de questions, notamment en matière de facilité de construction et de correction, de fidélité de la notation et de risque de deviner (Bertrand et al., 2016):

Il a été reporté que les QCM peuvent surestimer les compétences (Bird et al., 2019; Lee, 2006) et qu’elles évaluent plutôt la reconnaissance de la bonne réponse, pas le souvenir de celle-ci sans indice (Lee, 2006; Epstein, 2007). On peut aussi argumenter qu’un patient réel ne se présente pas sous forme d’une QCM avec des propositions, mais avec beaucoup d’inconnues (Bird et al., 2019). D’un autre côté, les QR ne sont pas nécessairement mieux que les QCM (Hift, 2014). Au mieux, la combinaison de différents outils peut combler les faiblesses individuelles de chacun (Epstein, 2007).

Analyse d’items

Après une épreuve, il est avantageux d’identifier les questions qui devraient être modifiées pour la prochaine édition et même éventuellement écartées du score. Pour les critères de validité et de fidélité, il existe des mesures psychométriques pour évaluer la qualité des questions (Bertrand et al., 2016; Shank, 2021):

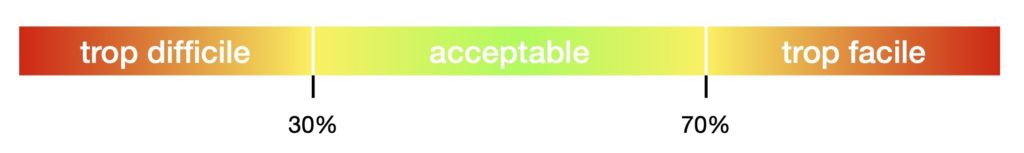

- L’indice de difficulté est le taux de réussite d’une question, c’est-à-dire le quotient entre le nombre des étudiants ayant répondu correctement par le nombre total d’étudiants. La littérature recommande un taux de réussite entre les 30% et 70% (Bertrand et al., 2016; Tavakol & Dennick, 2011). Une question à faible taux de réussite peut être mal formulée, non suffisamment couverte au cours ou représenter une matière intrinsèquement difficile.

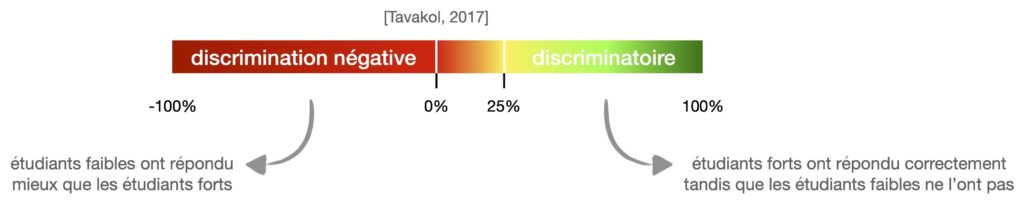

- L’indice de discrimination indique à quel point une question sait distinguer les étudiants forts (F) des étudiants faibles (f), selon le score total. Pour le calculer, on prend les 27% de l’effectif total (N) pour les groupes F et f respectivement (Tavakol & Dennick, 2011; Tavakol & Dennick, 2017). F et f représentant le nombre d’étudiants dans ces groupes ayant correctement répondus à une question, son indice de discrimination est calculé selon la formule 2*(F-f)/N. Les valeurs possibles se situent sur l’intervalle de -1 à +1. Une valeur positive indique qu’un étudiant fort quant au score total a plutôt correctement répondu, tandis qu’un étudiant faible a choisi la mauvaise réponse. Un indice de discrimination supérieur à 0,25 est recommandé. Une valeur négative indique une discrimination à l’envers. Une telle question pose problème, car elle peut être ambigüe ou peu connexe au reste de l’épreuve.

- L’analyse des distracteurs: Idéalement on a une répartition de réponses uniforme entre les distracteurs. Un distracteur peu choisi peut être non-plausible ou donner un indice.

- Le coefficient alpha de Cronbach: Il mesure la cohérence interne et peut donc estimer la fidélité.

Outils techniques

Notre offre actuelle d’outils digitaux comprend des éléments venant avec des quiz intégrés:

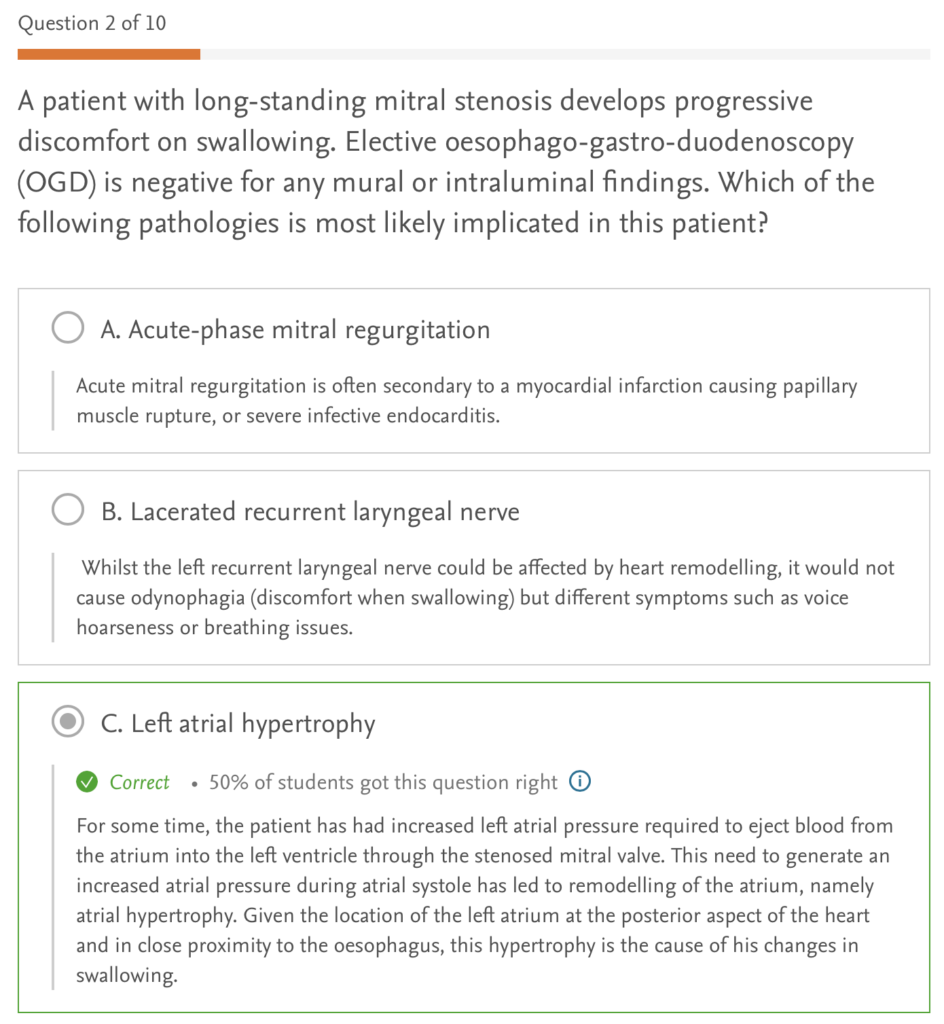

- ClinicalKey Student: Ce recueil de livres de référence offre un vaste ensemble de QCM (en anglais) sur différents sous-domaines de la médecine. Ces questions sont particulièrement intéressantes pour l’évaluation formative, car elles donnent un retour détaillé aux étudiants pourquoi une proposition est correcte ou fausse.

- Wooclap: Ce student response system fut exposé lors de la première édition du cycle de formations, et est le parfait outil pour réaliser des quiz interactifs en cours, vu ses multiples types de question au-delà des QCM.

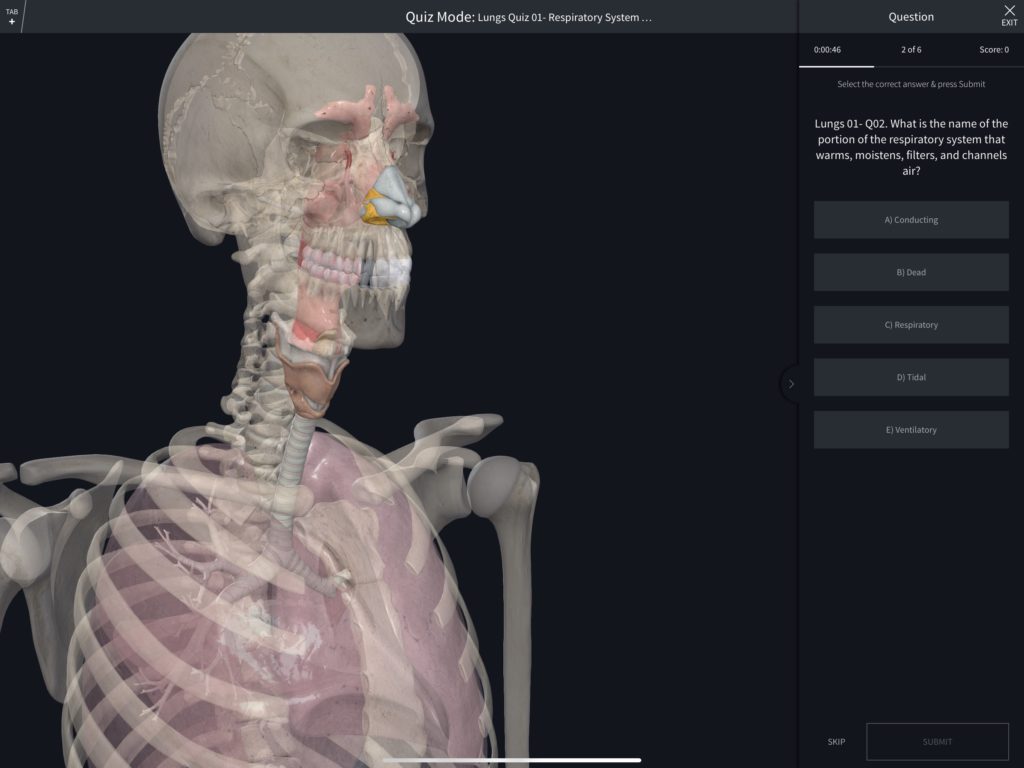

- Complete Anatomy: Cet outil combine son atlas 3D d’anatomie avec des QCM, permettant une vraie immersion dans le sujet via cet aspect multimédia.

- Moodle: Outre les QCM, ce learning management system peut être étendue via des plugins, permettant des types de questions pour annoter des images, voire analyser des lames histologiques (Lianas et al., 2016).

- SonoSim, Labster et JoVE également contiennent des quiz.

Conclusion

Cette séance a permis de revoir les différentes formes d’évaluation ainsi que ses différents outils. Il est très important d’assurer l’alignement pédagogique entre l’enseignement et l’évaluation. Créer des bonnes QCM requiert du temps et de l’exercice, les bonnes pratiques susmentionnées n’étant que le début. Certains participants ont admis après la séance d’avoir sous-estimé ce défi. Finalement, les mesures psychométriques permettent a posteriori d’évaluer la qualité de l’évaluation, et les outils techniques peuvent faciliter certains aspects, comme notamment la correction automatique et le retour.

Recommendations de lecture

Les chapitres 18 à 20 de ce livre abordent les principes généraux de l’évaluation et comment choisir, construire et utiliser un outil d’évaluation. Certains éléments ont été repris dans cet exposé.

Ce petit guide revoit les bonnes pratiques sur la construction et l’évaluation des QCM, avec beaucoup d’exemples.

Bibliographie

- Bertrand, C., Dory, V., Pelaccia, T., Charlin, B., & Hodges, B. (2016). Comprendre les principes généraux de l’évaluation. In T. Pelaccia (Ed.), Comment (mieux) former et évaluer les étudiants en médecine et en sciences de la santé? (pp. 343–355). De Boeck Supérieur.

- Bertrand, C., Dory, V., Pelaccia, T., Durand, E., Vaux, J., Charlin, B., & Hodges, B. (2016). Choisir un outil d’évaluation. In T. Pelaccia (Ed.), Comment (mieux) former et évaluer les étudiants en médecine et en sciences de la santé? (pp. 357–370). De Boeck Supérieur.

- Bertrand, C., Pelaccia, T., Durand, E., Revaux, F., Leveque, M., Delacour, C., Montandon, F., Charlin, B., & Hodges, B. (2016). Construire et utiliser les outils d’évaluation choisis. In T. Pelaccia (Ed.), Comment (mieux) former et évaluer les étudiants en médecine et en sciences de la santé? (pp. 371–396). De Boeck Supérieur.

- Bird, J. B., Olvet, D. M., Willey, J. M., & Brenner, J. (2019). Patients don’t come with multiple choice options: Essay-based assessment in UME. Medical Education Online, 24(1). https://doi.org/10.1080/10872981.2019.1649959

- Bloom, B. S. (1956). Taxonomy of educational objectives: The classification of educational goals. Allyn; Bacon.

- Epstein, R. M. (2007). Assessment in medical education. New England Journal of Medicine, 356(4), 387–396. https://doi.org/10.1056/NEJMra054784

- Hift, R. J. (2014). Should essays and other “open-ended”-type questions retain a place in written summative assessment in clinical medicine? BMC Medical Education, 14(1). https://doi.org/10.1186/s12909-014-0249-2

- Jones, E. P., & Wisniewski, C. S. (2021). Video killed the multiple-choice quiz: Capturing pharmacy students’ literature searching skills using a screencast video assignment. Journal of the Medical Library Association : JMLA, 109(4), 672–676. https://doi.org/10.5195/jmla.2021.1270

- Lee, C. (2006). Written tests — selected-response format (multiple-choice, matching, extended matching, pick n and true-false questions). In G. Bandiera, J. Sherbino, & J. R. Frank (Eds.), The CanMEDS assessment tools handbook: An introductory guide to assessment methods for the CanMEDS competencies (pp. 15–17). Royal College of Physicians; Surgeons of Canada.

- Lianas, L., Piras, M. E., Musu, E., Podda, S., Frexia, F., Ovcin, E., Bussolati, G., & Zanetti, G. (2016). CyTest – an innovative open-source platform for training and testing in cythopathology. Procedia – Social and Behavioral Sciences, 228, 674–681. https://doi.org/10.1016/j.sbspro.2016.07.103

- Miller, G. E. (1990). The assessment of clinical skills/competence/performance. Academic Medicine, 65(9), 63–67. https://doi.org/10.1097/00001888-199009000-00045

- Nilson, L. B. (2016). Constructing student assessments for grading. In Teaching at its best : A research-based resource for college instructors. Wiley.

- Shank, P. (2021). Write better multiple-choice questions to assess learning: Measure what matters — evidence-informed tactics for multiple-choice questions. Learning Peaks LLC.

- Tavakol, M., & Dennick, R. (2011). Post-examination analysis of objective tests. Medical Teacher, 33(6), 447–458. https://doi.org/10.3109/0142159X.2011.564682

- Tavakol, M., & Dennick, R. (2017). The foundations of measurement and assessment in medical education. Medical Teacher, 39(10), 1010–1015. https://doi.org/10.1080/0142159X.2017.1359521

- Vachon Lachiver, Élise, St-Onge, Christina, Cloutier, Jacinthe, & Farand, Paul. (2017). La rédaction de questions à choix multiple et de questions à réponse ouverte et courte pour les examens écrits dans les programmes de formation en santé: Une étude docimologique des consignes de rédaction. Pédagogie Médicale, 18(2), 55–64. https://doi.org/10.1051/pmed/2018002